Ngày 21/8/2017, 116 chuyên gia hàng đầu trong lĩnh vực robotics và trí tuệ nhân tạo (AI) đã cùng nhau ký tên vào một bức thư ngỏ gửi lên Liên Hợp Quốc (LHQ) kêu gọi ban hành một lệnh cấm triệt để và ngay lập tức việc phát triển và sử dụng các hệ thống vũ khí tự động giết người nhằm ngăn chặn hiểm họa về "cuộc cách mạng chiến tranh lần thứ ba".

Tham gia ký tên là những lãnh đạo, chuyên gia công nghệ robotics và IA hàng đầu thế giới đến từ 26 quốc gia, gồm cả Nga, Israel, Anh, Pháp, Hàn Quốc và Trung Quốc. Nổi bật trong số đó là những tên tuổi tiếng tăm trong giới công nghệ AI như Elon Musk - nhà sáng lập SpaceX và Tesla hay Mustafa Suleyman – Giám đốc Chương trình trí tuệ nhân tạo ứng dụng của Google DeepMind.

Bức thư gửi lên LHQ có đoạn viết: "Các vũ khí tự động giết người đang có nguy cơ trở thành một cuộc cách mạnh thứ 3 trong chiến tranh. Một khi được phát triển, chúng sẽ cho phép các cuộc xung đột vũ trang diễn ra ở quy mô lớn chưa từng thấy và với thời gian nhanh hơn những gì con người có thể tưởng tượng".

Các chuyên gia ký tên trong bức thư cũng cảnh báo: "Những vũ khí này có thể rơi vào tay khủng bố, được những kẻ độc tài và khủng bố sử dụng chống lại thường dân vô tội. Chúng có thể bị lợi dụng cho những mục đích không mong muốn. Chúng ta không còn nhiều thời gian để hành động. Một khi chiếc hộp Pandora được mở ra, thật khó có thể đóng lại".

Theo lý giải của nhóm vận động, robot giết người sẽ là công nghệ nòng cốt tạo nên "cuộc cách mạng thứ ba" trong chiến tranh, sau cuộc cách mạng thứ nhất gắn liền với sự phát triển của thuốc súng và cuộc cách mạng thứ hai là vũ khí hạt nhân.

Các tác giả của bức thư cho rằng, hai tiến bộ công nghệ đầu tiên thực tế đã không góp phần cải thiện thế giới con người đang sống.

"Không giống với các ứng dụng tiềm ẩn khác của AI - những thứ vẫn còn trong phạm vi của khoa học viễn tưởng, các hệ thống vũ khí tự động đang được phát triển ngay lúc này và đang hiện hữu nguy cơ gây tổn hại lớn cho người dân vô tội đi kèm với sự bất ổn toàn cầu", Ryan Gariepy, nhà sáng lập Clearpath Robotics nhấn mạnh.

"Đó không phải là một viễn cảnh giả tưởng mà là rất thực. Một lo ngại khẩn cấp cần hành động ngay".

Đây không phải lần đầu tiên Elon Musk và các đồng nghiệp cùng quan điểm lên tiếng kêu gọi LHQ ủng hộ một lệnh cấm các hệ thống vũ khí tự động giết người.

Năm 2015, 700 nhà nghiên cứu và hơn 600 chuyên gia khác gồm cả Elon Musk, nhà vật lý lỗi lạc người Anh Stephen Hawking, đồng sáng lập hãng Apple Steve Wozniack và đồng sáng lập ứng dụng Skype Jaan Talinn cũng đã gửi một bức thư tương tự cho một hội nghị uy tín quốc tế về AI tổ chức cùng năm.

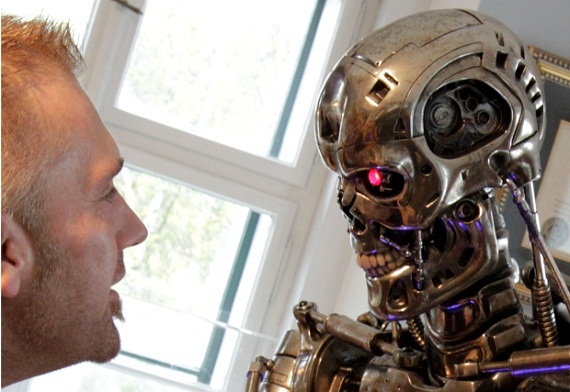

"Robot sát thủ" là gì?

Theo các chuyên gia, vũ khí tự động giết người (LAW) là một loại robot quân sự được thiết kế để định vị và tấn công các mục tiêu quân sự (gồm cả binh lính và căn cứ) mà không cần có sự can thiệp của con người.

LAW còn có một số tên gọi khác như: hệ thống vũ khí tự động giết người (LAWS), robot tự động giết người (LAR) hoặc ngắn gọn hơn là robot giết người hoặc "robot sát thủ" (Killer Robots).

"Robot sát thủ" có thể hoạt động trong mọi không gian tác chiến: trên không, trên bộ, dưới nước, trên biển hoặc trong vũ trụ.

Cũng như nhiều khái niệm còn mới mẻ khác, không phải tất cả mọi người đều chia sẻ chung quan điểm về định nghĩa "robot sát thủ", kể cả những chuyên gia gạo cội trong lĩnh vực robotics và AI.

Theo Clearpath Robotics, "robot sát thủ" là một robot có thể đưa ra quyết định sử dụng lực lượng sát thương mà không cần tới sự can thiệp của con người. Trong khi đó, Tổ chức theo dõi nhân quyền quốc tế (HRW) đưa ra khái niệm bao trùm hơn, gồm cả bất kỳ robot nào có thể lựa chọn sử dụng lực lượng chống lại con người, thậm chí lực lượng đó không gây chết người.

Nhưng tựu chung lại, gần như tất cả các định nghĩa đều chia sẻ chung một quan điểm: "Robot sát thủ" sẽ tự đưa ra quyết định hạ sát mục tiêu mà không cần tới mệnh lệnh của người điều khiển.

Đây chính là nguy cơ và là viễn cảnh cực kỳ nguy hiểm được các chuyên gia cảnh báo và kêu gọi LHQ ban hành một lệnh cấm. Nếu không, ranh giới đạo đức giữa con người và máy móc sẽ bị phá vỡ.

Cảnh báo về những viễn cảnh khủng khiếp

Trong vài năm trở lại đây, rất nhiều chuyên gia đã lên tiếng cảnh báo công nghệ AI đang đạt tới ngưỡng mà việc phát triển các vũ khí tự động có thể thực hiện được chỉ trong vài năm thay vì vài thập kỷ nữa.

Xét về mặt tích cực, AI có thể được sử dụng với mục đích giúp chiến trường trở thành nơi an toàn hơn, giảm thương vong cho các binh sĩ.

Nhưng cũng chính những mặt lợi này lại càng khiến các chuyên gia lo ngại hơn vì như thế sẽ giúp các nhà chính trị hoặc lãnh đạo quốc gia đi đến quyết định phát động chiến tranh nhanh hơn, qua đó gây hậu quả lớn đối với tính mạng con người.

"Gần như tất cả mọi công nghệ đều có thể sử dụng cho cả mục đích tốt và mục đích xấu, và trí tuệ nhân tạo cũng không phải ngoại lệ.

Nó có thể giúp giải quyết rất nhiều vấn đề thách thức mà xã hội đang phải đối diện hiện nay như: nghèo đói, bất bình đẳng, biến đổi khí hậu và khủng hoảng tài chính toàn cầu", Toby Walsh, giáo sư về trí tuệ nhân tạo của Đại học New South Wales ở Sydney nhận xét.

"Tuy nhiên, công nghệ này cũng có thể được sử dụng trong các vũ khí tự động để thương mại hóa chiến tranh. Chúng ta cần đưa ra quyết định ngay hôm nay để lựa chọn tương lai mà chúng ta mong muốn".

Trong khi đó, các tổ chức quốc tế vẫn còn đang đi sau thế giới công nghệ trong việc xây dựng các chính sách bảo vệ. Hiện chưa có các tiêu chuẩn hay quy định đa phương nào kiểm soát ứng dụng AI trong quân sự.

Izumi Nakamitsu, Đại diện cấp cao về Các vấn đề Giải trừ quân bị của LHQ cảnh báo, sự chậm trễ này sẽ đặc biệt thảm khốc trong lĩnh vực vũ khí tự động giết người.

"Đang tồn tại một mối nguy hiện hữu rằng nếu không có hành động kịp thời, sáng tạo công nghệ sẽ vượt khỏi tầm giám sát của con người trong lĩnh vực này", bà Nakamitsu nói.

Theo HRW, điều rất đáng lo ngại là con người sẽ ít liên quan tới tiến trình lựa chọn và khai hỏa nhằm vào các mục tiêu. Các máy móc, dù thiếu khả năng phán đoán hay cân nhắc như con người, sẽ bắt đầu đóng vai trò trọng yếu trong chiến tranh. Khi đó, không có gì đảm bảo ranh giới đạo đức sẽ không bị bỏ qua.

"Những nguy cơ về nhân đạo và anh ninh lớn hơn bất cứ lợi ích quân sự nào có thể có. Những người chỉ trích mối lo ngại này chỉ dựa trên những lập luận phỏng đoán về tương lai công nghệ và giả định sai rằng những tiến bộ về kỹ thuật có thể giải quyết nhiều nguy cơ do những vũ khí tương lai này mang lại".

Elon Musk, doanh nhân Mỹ nổi tiếng với những ý tưởng tiên phong về trí tuệ nhân tạo từng phát biểu:

"AI là một mối nguy hiểm cơ bản với tương lai văn minh nhân loại theo cách mà các dạng tai nạn giao thông, va chạm máy bay, thuốc gây nghiện hay thức ăn bẩn đều chưa đem đến. Chúng có thể gây hại với một nhóm người trong xã hội nhưng chúng không gây hãi cho toàn thể con người như robot sát thủ".

Từ nhiều năm nay, Elon Musk đã cảnh báo mạnh mẽ về hiểm họa của trí tuệ nhân tạo, cho rằng nó tiềm ẩn những nguy cơ còn nguy hiểm hơn cả vũ khí hạt nhân.

Bức thư năm 2015 mà Elon Musk là một thành viên ký tên viết: "Không giống với vũ khí hạt nhân, vũ khí giết người tự động không đòi hỏi nhiều nguyên liệu thô khó kiếm hay tốn kém chi phí. Vì thế, chúng sẽ rất dễ dàng để cho các cường quốc quân sự có thể sản xuất đồng loạt".

"Khi nào chúng sẽ xuất hiện trên thị trường chợ đen, rơi vào tay khủng bố, những kẻ độc tài, sẽ chỉ còn là vấn đề thời gian…Vũ khí tự động sẽ rất lý tưởng cho các hoạt động như ám sát, gây mất ổn định quốc gia, đàn áp người dân và lựa chọn giết hại một nhóm thiểu số nào đó".